数据处理是现代企业和科研机构面临的核心任务之一。随着数据量的爆炸式增长,有效的数据处理不仅关乎业务效率,更是决策科学性的基础。

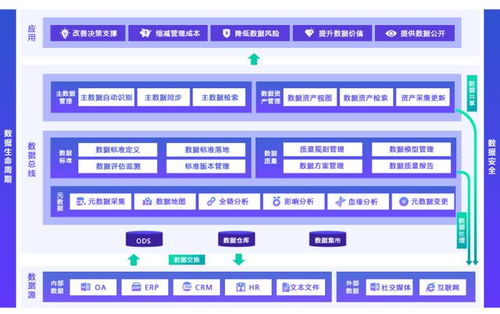

数据采集是数据处理的基础。从传感器、交易记录到社交媒体,数据来源多样且复杂。确保数据质量和一致性是这一阶段的关键挑战。常见的方法包括数据清洗、去重和格式标准化,以消除噪声和异常值。

数据存储和管理需要可靠的架构。传统的关系型数据库与新兴的NoSQL系统并存,选择取决于数据类型和查询需求。云存储解决方案如AWS S3或Google Cloud Storage提供了可扩展性,但需注意数据安全和合规性问题。

接着,数据处理本身涉及转换、聚合和分析。ETL(提取、转换、加载)流程是常见手段,而实时流处理技术如Apache Kafka则支持即时响应。机器学习和AI工具的集成进一步提升了数据价值提取能力,例如通过Python的Pandas库进行数据操作,或使用TensorFlow构建预测模型。

数据可视化是最后一步,将处理结果转化为直观图表或仪表板。工具如Tableau或Power BI帮助用户识别趋势,做出数据驱动的决策。隐私和伦理问题不容忽视,需遵循GDPR等法规,确保匿名化和权限控制。

高效的数据处理要求整合技术、工具和流程,同时关注安全与合规。随着技术的发展,自动化与智能化将成为未来趋势,助力组织在数据洪流中保持竞争力。